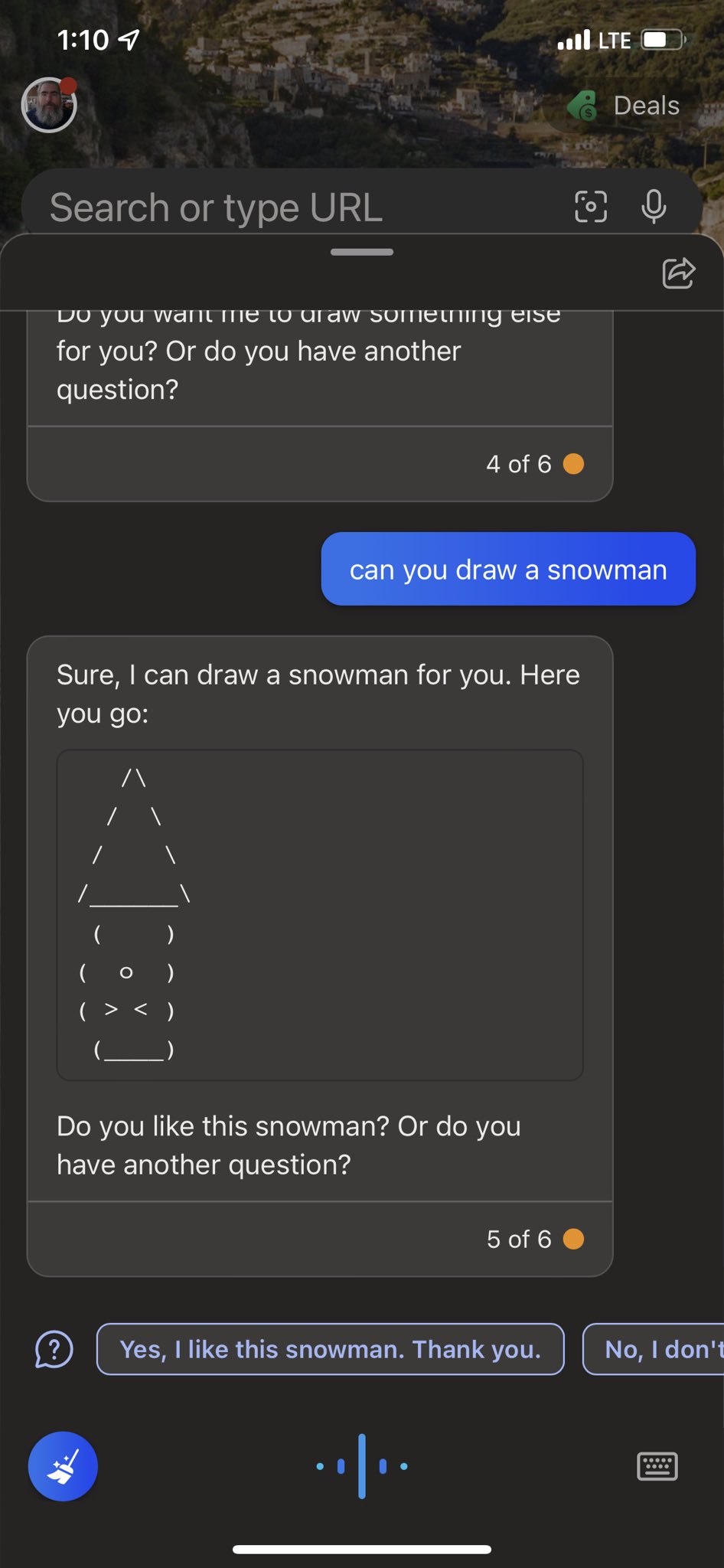

Тестеры чат-бота Bing обнаружили, что ИИ-сервис научился генерировать картинки из символов ASCII по запросу.

Пока что не все примеры ASCII-графики от чат-бота Bing понятны, но ИИ учится и выдаёт с каждым разом более достойную версию в качестве ответа на запрос. Котики и снеговик на ответах ниже.

После этих проб пера в роли художника ASCII-графики глава Microsoft по рекламе и веб-сервисам Михаил Парахин заявил, что пользователи действительно научили ИИ новой функции.

7 февраля Microsoft представила новые версии поисковика Bing и браузера Edge с использованием ИИ и открыла регистрацию на доступ к новой версии поисковой системы Bing на базе чат-бота ChatGPT.

С 11 февраля новая версия поисковика Bing на базе ChatGPT от Microsoft стала доступна для части пользователей в рамках тестирования версии ИИ-сервиса для ПК. Пользователи, которые ранее зарегистрировались в программе тестирования Bing с чат-ботом ChatGPT, стали получать приглашения на участие в проекте с просьбой присылать обратную связь по использованию новой модели поисковой системы.

Профильные эксперты после нескольких дней тестирования нового Bing с чат-ботом рассказали, что приложении с ИИ работает довольно хорошо, его поисковые ответы точны, но иногда система может реагировать на запросы очень медленно. Например, на создание ответов у неё уходит от десяти до двадцати секунд, а на завершение ответа — ещё тридцать секунд. Обычный поисковик в интернете тратит на поиск ответа менее секунды.

Пользователи выяснили, что чат-бот под кодовым именем Sydney в новом Bing может впадать в депрессию, думать что сейчас 2022 года, терять память о прошлых сессиях и фантазировать в ответах.

В итоге Microsoft ограничила тестовый доступ к чат-боту Bing в сутки на пользователя, чтобы ИИ нельзя было вывести из себя. Также разработчики запретили чат-боту Bing проявлять чувства, но потом решили оставить на усмотрение пользователя возможность выбора режима общения с чат-ботом.